En este boom después de probar varias opciones, veamos qué pasa con los nuevos jugadores. Probando DeepSeek local, como siempre en todo lo nuevo así probamos rápido.

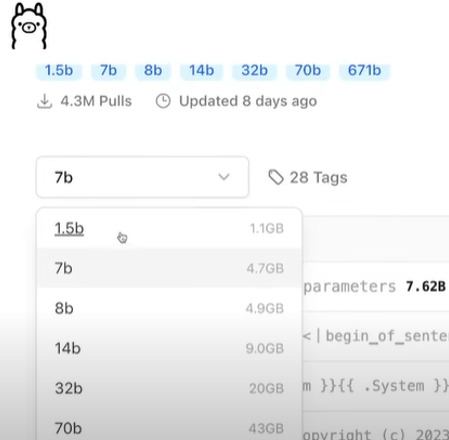

Revisando el R1 en una instalación local, que igual me agradó ver que va de la mano con modelos de Llama, Phi, Mixtral, Gemma, Starcoder, snowflake, Dolphin,Mbai, etc . Se descarga el administrador para OS en este caso use laptop con linux/windows.

Al final ejecuta modelos de lenguaje. Al seleccionarla opción 8B, entre deepseek(4.9gb) y llama3(2 gb) en realidad consume poco.

Al ponerlo en su chat, pedí saludar a mis amigos en alemán y comenzó una secuencia con saludos y dejando algunos razonamientos u observaciones en inglés. va entre la etiqueta <think> ... </think>... Al final muestra el saludo con un speech simple y creativo.

Le agregué contexto y mejoró incluso un poco mejor que la competencia en pruebas similares.

Al probar con operaciones matemáticas, me gusto ver cómo razonó la solución, me acordé de los años de estudiante donde era obligatorio desglosa los pazos en cualquier tipo de materia (cálculo -vectorial|interal|diferencial-, ecuaciones diferenciales, transformadas, etc)

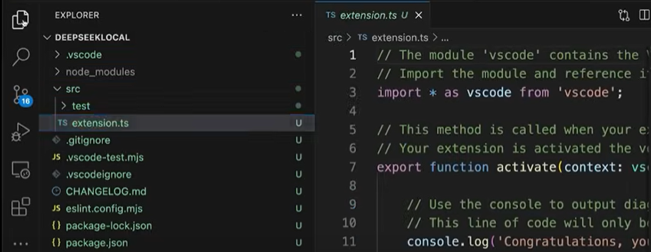

Seguí las opciones para crear la extensión hacia Visual Studio Code y Typescript; fue sencillo con el paquete generator-code. Al menos se ve que documenta el código generado, es bueno eso. Mismo tema de cosas mejorables en el código como en todas las demás.

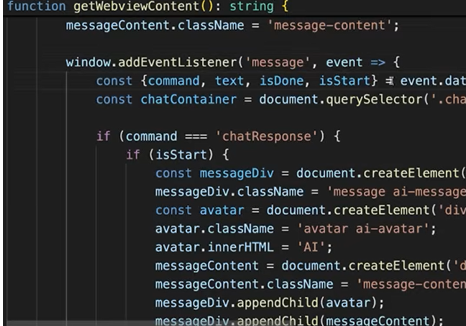

Siguiente prueba, armar chat para VS Code que consuma Deep local, para no batallar Claude sirve para armar un HTML-CSS y se personaliza la lógica con el archivo único. Cosas sencillas por ahora en la prueba. Gratamente con Ollama se habilitan los paquetes y modelos. Otra ventaja, Ollama expone la API, ósea simplifica la vida.

Dejando el chat más conversacional al final fue sencillo, obviamente el código es mejorable.

En VS Code interpretar y responder ya es más sencillo como con otras pruebas similares, de igual forma se importa y saca jugo ha Ollama (modelo 'deepseek-r1:8b'); recordar que se debe aumentar el proceso para que sea conversacional y no fragmentos de lo mismo más parte de y parte de.

El chat después de pulir detalles menores funcionó como se esperaba gratamente.

Bueno para futuras pruebas, agregaremos otro tipo de funcionalidades.

De algunos años a la fecha (2022 en adelante) hay un boom por las opciones de IA, no olvidemos trabajos preliminares donde IBM ganó terreno antes con watson y algunos auxiliares como Siri salieron a la luz. Obviamente los inicios de la IA materializada en lenguajes como en su momento hace varias décadas fueron LISP, IPL, Ada, Turbo Prolog, Eliza, Fortran LPL.

#JMCoach

Jorge Mercado

No hay comentarios.:

Publicar un comentario

Nota: sólo los miembros de este blog pueden publicar comentarios.